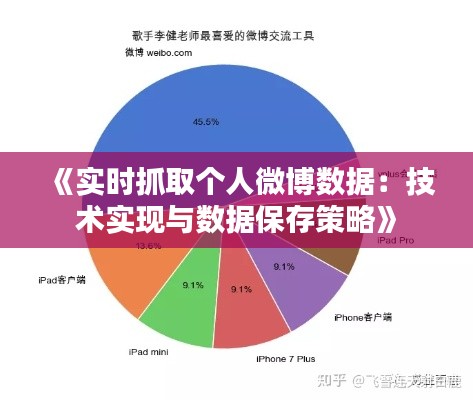

标题:《实时抓取个人微博数据:技术实现与数据保存策略》

随着互联网的飞速发展,微博作为一种新兴的社交媒体平台,已经成为人们获取信息、交流观点的重要渠道。对于企业和个人来说,实时爬取个人微博数据,对于市场分析、品牌推广、舆情监控等方面具有重要意义。本文将介绍实时爬取个人微博的技术实现方法,并探讨数据保存策略。

一、实时爬取个人微博技术实现

- 选择合适的爬虫框架

目前,Python语言在爬虫领域应用广泛,其丰富的库和框架为爬虫开发提供了便利。常见的爬虫框架有Scrapy、BeautifulSoup、Requests等。本文以Scrapy框架为例,介绍实时爬取个人微博的技术实现。

- 分析微博网页结构

首先,我们需要分析微博网页的结构,了解数据存储的位置。通过观察微博网页的源代码,我们可以发现微博用户信息、微博内容、评论等数据都存储在HTML标签中。

- 编写爬虫代码

(1)创建Scrapy项目

在命令行中,执行以下命令创建Scrapy项目:

scrapy startproject weibo_spider(2)创建爬虫

在项目目录下,创建一个名为weibo_spider.py的爬虫文件,并编写以下代码:

import scrapy

class WeiboSpider(scrapy.Spider):

name = 'weibo_spider'

allowed_domains = ['weibo.com']

start_urls = ['https://weibo.com/']

def parse(self, response):

# 解析微博用户信息

user_info = response.xpath('//div[@class="profile_box"]')

# 提取用户名、头像、粉丝数等数据

username = user_info.xpath('.//a/text()').extract_first()

avatar = user_info.xpath('.//img/@src').extract_first()

fans_count = user_info.xpath('.//a/text()').extract_first()

# 解析微博内容

weibo_content = response.xpath('//div[@class="weibo_content"]')

# 提取微博内容、发布时间等数据

content = weibo_content.xpath('.//p/text()').extract_first()

publish_time = weibo_content.xpath('.//time/text()').extract_first()

# 解析评论

comments = weibo_content.xpath('.//div[@class="comment_box"]')

# 提取评论内容、评论时间等数据

comment_content = comments.xpath('.//p/text()').extract_first()

comment_time = comments.xpath('.//time/text()').extract_first()

# 将数据存储到数据库或文件中

# ...

# 启动爬虫

if __name__ == '__main__':

from scrapy.crawler import CrawlerProcess

process = CrawlerProcess({

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

})

process.crawl(WeiboSpider)

process.start()- 运行爬虫

在命令行中,执行以下命令运行爬虫:

scrapy crawl weibo_spider二、数据保存策略

- 数据库存储

将爬取到的数据存储到数据库中,如MySQL、MongoDB等。数据库可以方便地进行数据查询、统计和分析。

- 文件存储

将爬取到的数据保存到文件中,如CSV、JSON等格式。文件存储简单易用,但数据查询和统计不如数据库方便。

- 分布式存储

对于大规模数据,可以考虑使用分布式存储方案,如Hadoop、Spark等。分布式存储可以提高数据存储和处理能力,适用于大数据场景。

总结

实时爬取个人微博数据对于企业和个人具有重要意义。本文介绍了实时爬取个人微博的技术实现方法,并探讨了数据保存策略。在实际应用中,可以根据需求选择合适的技术方案和数据存储方式。

转载请注明来自衡水悦翔科技有限公司,本文标题:《《实时抓取个人微博数据:技术实现与数据保存策略》》

冀ICP备2023036310号-1

冀ICP备2023036310号-1